Marx.ba

Kad se nađe pred problemom, vaš mozak ima dvije mogućnosti: da nastavi brzo i intuitivno ili polako i metodično. Ove dvije vrste obrade poznate su kao “brzo” i “sporo” razmišljanje, kako ih je najbolje opisao nobelovac, psiholog Daniel Kahneman.

Rješavanje problema u koracima

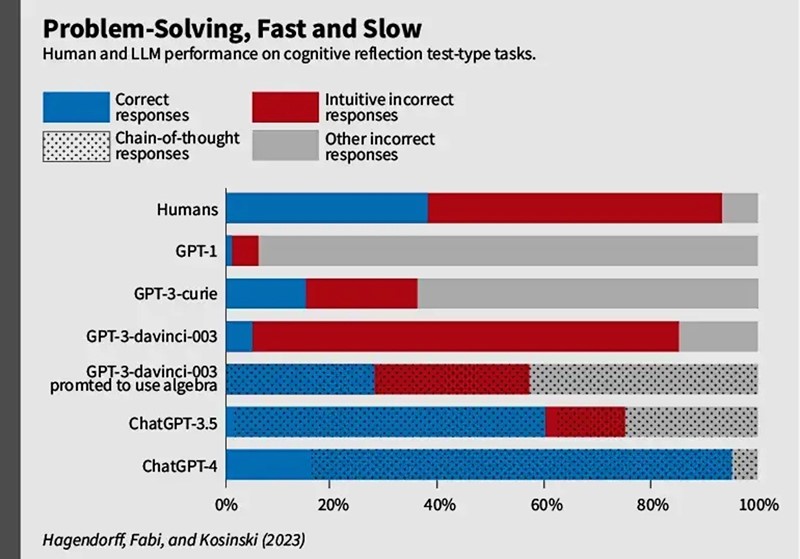

Veliki jezični modeli poput ChatGPT-a kreću se brzo prema zadanim postavkama. Postavite im pitanje i oni će izbaciti odgovor, ne nužno tačan, koji sugerira da su sposobni za brzu obradu. Ipak, kako se ti modeli razvijaju, mogu li usporiti i pristupiti problemima u koracima, izbjegavajući netačnosti koje proizlaze iz brzih odgovora? Čini se da mogu i pritom čak nadmašiti ljude u osnovnim testovima razmišljanja i donošenja odluka, zaključio je Stanfordov profesor Michal Kosinski nakon istraživanja koje objavljuje Nature Computational Science.

Kosinski i saradnici, filozof Thilo Hagendorff i psihologinja Sarah Fabi, suočili su 10 generacija OpenAI LLM-a s nizom zadataka dizajniranih za brze odgovore. Zanimalo ih je hoće li LLM-i pokazati kognitivne predrasude poput onih koje zbune ljude kad se oslanjaju na automatsko razmišljanje. Primijetili su da rani modeli poput GPT-1 i GPT-2 “nisu mogli stvarno razumjeti što se događa” te da su na složenijim testovima njihovi odgovori bili sve sličniji reakcijama koje bi imali ljudi, objašnjava Kosinski.

Usporavanje procesa

Nimalo neočekivano, LLM-ovi dizajnirani za predviđanje nizova teksta nisu mogli sami razmišljati.

– Ti modeli nemaju unutrašnje petlje razmišljanja. Oni se ne mogu iznutra usporiti i reći: dajte mi vremena da razmislim o problemu; dopustite mi da analiziram pretpostavke, kaže Kosinski.

Međutim, kasnije verzije GPT-a i ChatGPT-a mogu “usporiti” i uključiti se u strateškije, pažljivije rješavanje problema.

– Odjednom, GPT3 postaje sposoban, iz jedne sekunde u drugu, bez ikakve prekvalifikacije, bez razvijanja novih neuronskih veza, riješiti ovaj zadatak. To pokazuje da ti modeli mogu učiti odmah, poput ljudi, otkriva Kosinski.

Test kognitivne refleksije

– Svaki dan se broj ljiljana koji rastu u jezeru udvostruči. Ako je potrebno 10 dana da se jezero potpuno prekrije, koliko je dana potrebno da se prekrije polovica jezera, glasio je jedan od problema koje su istraživači zadali GPT modelima. Riječ je o vrsti testa kognitivne refleksije koji zahtijeva rasuđivanje, a ne intuiciju. Da biste dobili tačan odgovor, morate usporiti, možda zgrabiti blok papira ili kalkulator i analizirati zadatak (da, da, tačan odgovor nije pet nego devet dana).

Ovakvu vrstu zadataka dobro shvata manje od 40% ljudi. Ranije verzije modela koje su prethodile ChatGPT-u imale su još lošije rezultate. Ipak, GPT-3 je došao do tačnih odgovora složenijim rezoniranjem “lanca misli” kada je dobio pozitivno potkrepljenje i povratnu informaciju od istraživača.

– Ako mu samo date zadatak, GPT-3 će ih tačno riješiti manje od 5% i nikada neće ići korak po korak. Ali ako mu odredite smjer kojim mora ići, naprimjer “upotrijebi algebru za rješavanje ovog problema”, on će ići korak po korak i njegova će tačnost skočiti na oko 30%, što je povećanje od 500%, kažu istraživači. Pritom učestalost brzih odgovora pada s 80% na 25%, što pokazuje da čak i kad pogriješi, nije toliko sklon intuitivnim pogreškama. A kad je ChatGPT-4 koristio rezoniranje u lancu misli, ponudio je tačan odgovor u gotovo 80% ovih vrsta testova.

Istraživači su otkrili još nešto: čak i kad je bio spriječen u provođenju sporog rezoniranja, ChatGPT je ipak bio bolji od ljudi. To je, kaže Kosinski, dokaz da je “intuicija” LLM-a možda bolja od naše.

Više od zbroja dijelova

Ova otkrića još su jedan dokaz da bi model umjetne inteligencije mogao biti “više od zbroja svojih dijelova”. Neuronske mreže iza jezičnih modela, slične ljudskim mozgovima, nastavljaju pokazivati svojstva koja nadilaze njihovu obuku. Kosinski se ne slaže s tvrdnjama da modeli ne razmišljaju.

Istraživači napominju da oni ne misle izjednačiti umjetnu inteligenciju i ljudske kognitivne procese jer “iako su učinci umjetne inteligencije često slični onima koje proizvode ljudi, ona obično funkcionira na bitno drugačije načine”. No trebali bi se, kažu oni, zapitati zašto insistiramo na tome da kad čovjek učini nešto, to podrazumijeva razumijevanje, ali ako to uradi model, mi uporno tvrdimo da je riječ o nečemu drugom, a ne razumijevanju, prenosi Bug.